2025 empieza fuerte: Vibe Coding, MCP y la era de los Agentes de IA

Estamos viviendo el amanecer de los agentes: lo mejor está por venir

Cuanto más exploro el estado actual de las herramientas de IA, más me cuestiono si realmente sigue siendo indispensable saber programar.

Bienvenidos a 2025, donde el vibe coding está tomando el escenario: un estilo de desarrollo en el que el programador se deja llevar por el flujo de la IA, que ya es capaz de generar código de alta calidad casi sin esfuerzo.

Este post es para ponernos al día con el estado actual del desarrollo de agentes de IA. Tanto si ya estás metido en el tema como si es la primera vez que escuchas hablar de esto, aquí encontrarás una introducción clara a lo que está resonando con fuerza en el mundo tech. Además, explicaré los conceptos técnicos de forma comprensible, para que cualquiera pueda entender cómo funcionan estas nuevas herramientas.

Y si LLM o MCP te suenan a siglas misteriosas, quédate hasta el final: hay un glosario esperándote.

Según Y Combinator, el 95% del código en las startups de su último batch (W25) fue generado con IA. No necesariamente porque los fundadores no sepan programar, sino porque, aún teniendo un perfil técnico altísimo, este enfoque rápido, fluido y casi intuitivo se ha convertido en la nueva norma al desarrollar.

Herramientas como Cursor o Windsurf están llevando esto aún más lejos, aprovechando agentes de IA y herramientas para generar código con una eficiencia brutal.

Lo puse en práctica

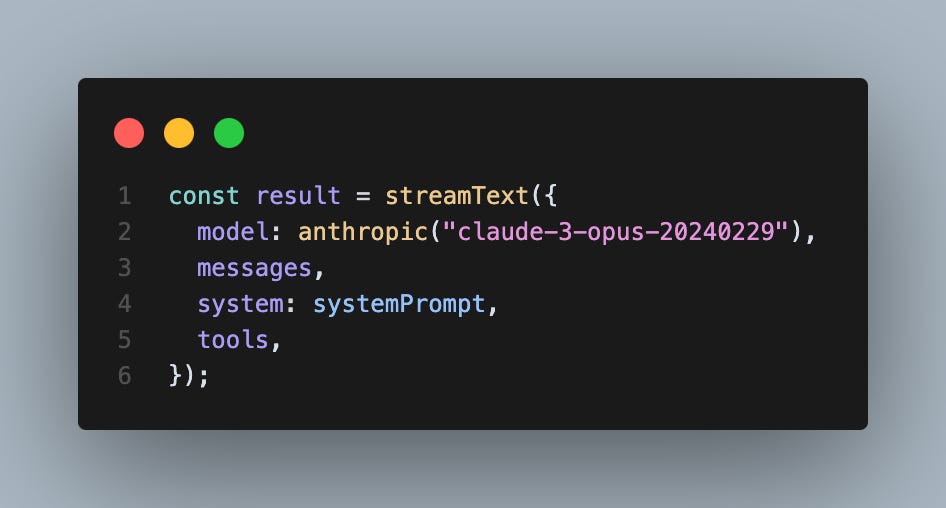

Lo probé yo mismo y, honestamente, me voló la cabeza: Sonnet 3.7 , por ejemplo, destaca en razonamiento y generación de código, y cuando lo combinas con el modo "agente" de Cursor, la experiencia es casi mágica: el sistema planifica, desglosa y ejecuta tareas completas a partir de un solo prompt.

Si a esto le sumamos el Model Context Protocol (MCP) de Anthropic, del que hablaremos más adelante, está claro que estamos en medio de una revolución en cómo consturimos software.

¿Cómo llegamos hasta acá?: De Wrappers a Agentes

Estamos viviendo el desarrollo de las bases para los próximos años, y se siente como los inicios del internet. Al principio, la gente tuvo que aprender a usar la red, proponer estándares y protocolos que hoy son tan comunes que ni los notamos. Luego vinieron las APIs: los desarrolladores preparaban sus apps para ser consumidas vía APIs, y del otro lado, había que aprender a integrarlas.

Ahora con la IA, parece que estamos en un punto de inflexión similar, pero esta vez la comunidad no esperó a que alguien dictara las reglas del juego.

Tan pronto como los primeros Large Language Models (LLMs) estuvieron disponibles, la experimentación se disparó. Los desarrolladores empezaron a hacerse preguntas prácticas: ¿qué pasaría si le doy a un modelo un prompt super específico, cargado con todo el contexto necesario para contestarlo? ¿Y si uso un LLM para organizar ideas y paso eso a otro LLM (prompt chaining)? ¿O si combino varios prompts con contexto completo?

Tomemos RAG (Retrieval-Augmented Generation) como ejemplo. En términos simples, es como darle a un LLM una memoria externa: antes de responder, el modelo busca información relevante en documentos o bases de datos, asegurándose de que su respuesta esté anclada en hechos y no en alucinaciones. No es magia, pero sí un salto enorme desde los modelos que solo improvisaban con lo que tenían en la cabeza. Esa capacidad de “buscar antes de hablar” abrió la puerta a experimentos mucho más ambiciosos.

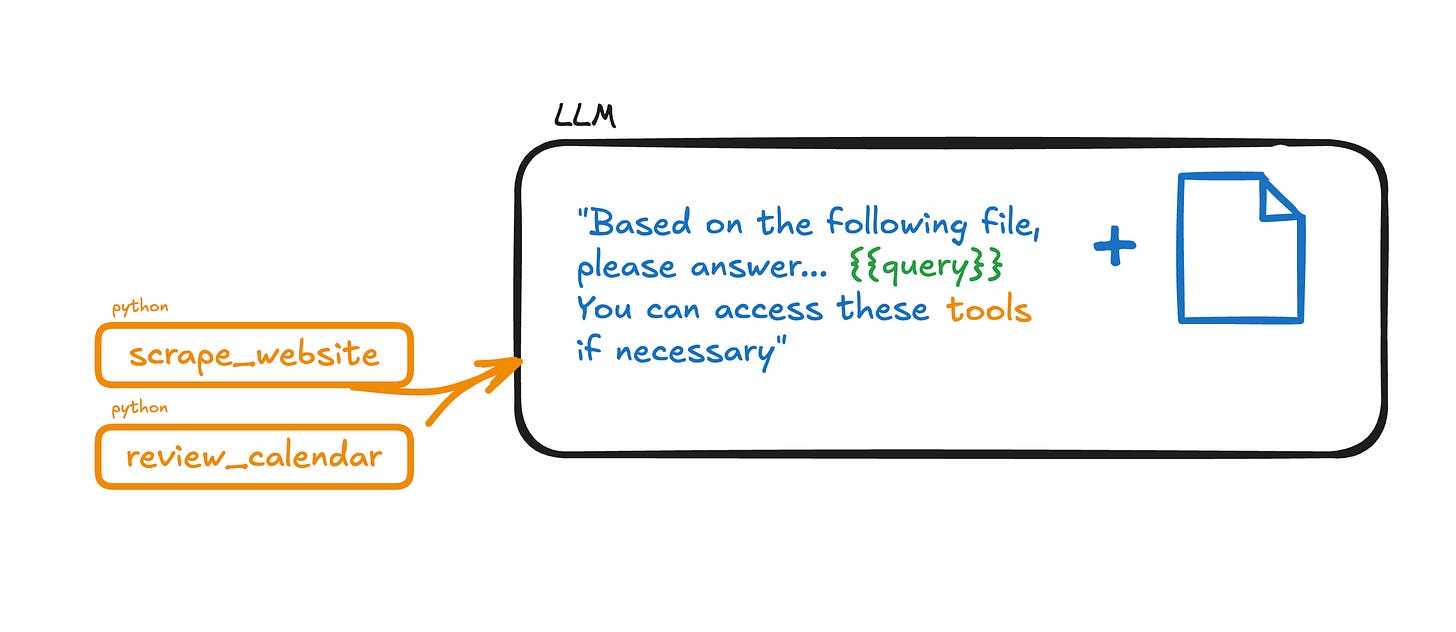

Luego llegó el function calling, o tool calling, un paso que se asimila al RPC (Remote Procedure Call) de los días de la programación distribuida.

La idea es simple pero poderosa: le das a un agente la habilidad de invocar funciones de código cuando las necesita. El agente entiende qué hace la función, qué parámetros requiere y la ejecuta como si fuera una extensión natural de sus capacidades.

Consideremos que estas funciones deben de tener nombres y parámetros intuitivos. Si un humano no los capta, un agente tampoco.

Pero entonces, ¿Un Agente es un LLM?

Al principio, reinaba el caos: cada equipo o investigador usaba términos distintos para las mismas ideas, o el mismo término para cosas diferentes. Anthropic dio un paso al frente con su artículo "Building Effective Agents", proponiendo un lenguaje común: workflows y agentes.

Workflows: sistemas en donde se coordina el uso de LLMs con flujos definidos.

Agentes: A diferencia de un LLM común, un agente de IA no solo genera texto, sino que también toma decisiones y ejecuta acciones.

Un agente de IA va más allá de una simple consulta y respuesta, porque puede:

Recordar y mantener estado: Un LLM por sí solo no tiene memoria persistente, pero un agente puede almacenar información a lo largo de una conversación o tarea.

Tomar decisiones dinámicas: Un agente no solo responde pasivamente, sino que decide cuándo usar herramientas externas, consultar bases de datos, llamar funciones o interactuar con APIs.

Adaptarse y ejecutar tareas complejas: Un LLM solo responde lo que le pides en un prompt, mientras que un agente puede dividir una tarea grande en pasos más pequeños, evaluar el resultado y adaptarse de manera dinámica en función de lo que va resolviendo.

Este cambio es clave porque ya no estamos hablando solo de modelos de lenguaje que generan texto, sino de sistemas completos que interactúan con el mundo digital para resolver tareas de manera más eficiente y flexible.

La propuesta de Anthropic va más allá, y el MCP es la prueba.

Entendiendo la propuesta

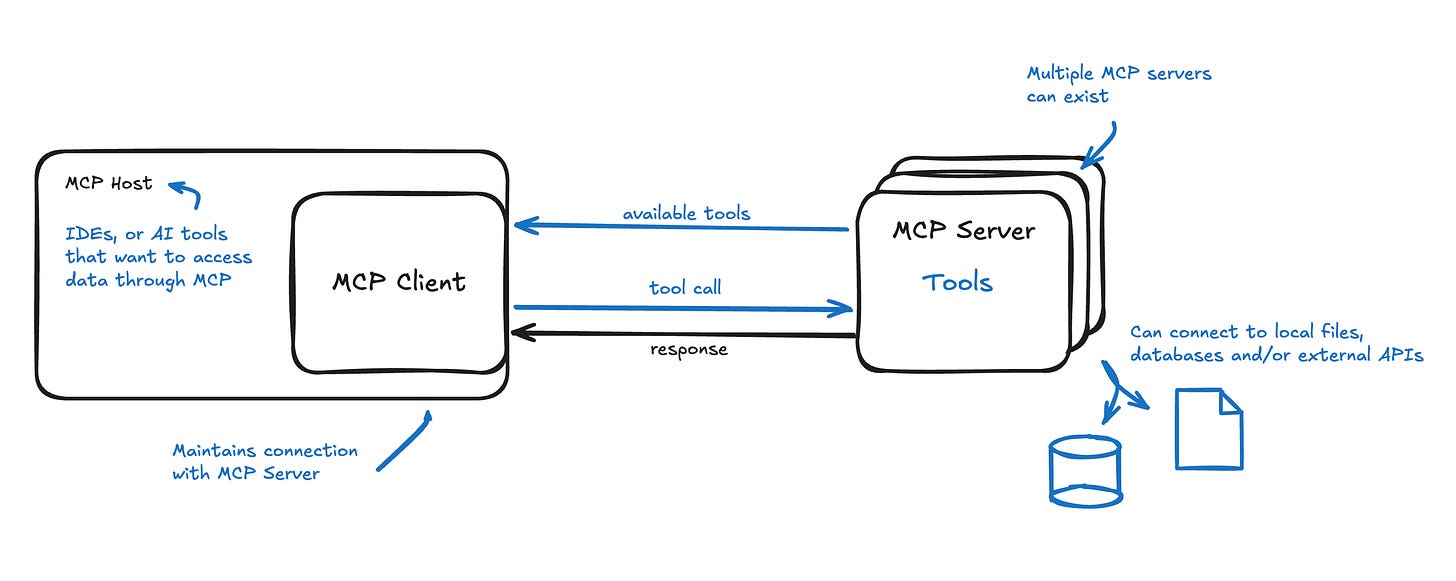

El Model Context Protocol (MCP) de Anthropic permite que los agentes usen herramientas alojadas remotamente en lugar de depender sólo de funciones locales.

Imagina esto: en vez de programar cada función que un agente necesita, este se conecta a un servidor que ya las tiene listas. Es un modelo cliente-servidor clásico: el agente pide, el servidor procesa, el host entrega, pero aplicado a la IA.

Por ejemplo, supongamos que Cursor implementa un cliente MCP. Podría conectarse a un servidor MCP y acceder a una función para leer tickets de Linear, sin integrar directamente su API. El agente usa la herramienta remota como si estuviera en su propio sistema.

Lanzado en noviembre de 2024, el MCP ya tiene miles de implementaciones en apenas tres meses.

Esto podría hacer que las APIs tradicionales queden obsoletas para los agentes. Lo que importa ahora es integrarse bien con servidores MCP. No solo se está estandarizando el lenguaje; se está redefiniendo cómo los agentes interactúan con un ecosistema mucho más amplio.

Recomendaciones: Cómo aprovechar esta ola

Si planeas meterte de lleno a construir agentes, te recomiendo leer el post de Anthropic donde comparten tips y recomendaciones muy valiosas.

Basado en eso y en lo que he observado, aquí van mis consejos favoritos:

El formato sí importa: JSON semiestructurado es sólido; Claude prefiere XML. Prueba y ajusta según tu caso de uso.

Orquestación eficiente:Usa modelos con buen razonamiento (Claude 3.5/3.7, OpenAI o3-mini, Deepseek R1) para decisiones complejas.

Piensa en grande: Una demo es fácil; un prodcto en producción necesita visión.

Guardrails: Valida respuestas antes de enviarlas. Evita sorpresas.

Fine-tuning, no gracias: Pierde tiempo; mejor prompts y tools bien hechos.

Límite de agentes: 5-7 por flujo, o se descontrola.

Premia al cerebro: Recompensa al agente que decide, no al que ejecuta.

Mocks: Pídele a la IA ejemplos de request/response para tus herramientas. Ahorra iteraciones.

Simplicidad: Si tu tool no es intuitivo, rediséñalo. El agente no resolverá el caos dentro de tu código.

Esto cambia todo.

Antes, refactorizar era un dolor de cabeza; nos apegábamos al código que íbamos armando paso a paso, como si fuera una obra maestra tallada en piedra. Tirarlo o rehacerlo desde cero sentía como traicionar nuestras propias horas de sudor. Pero ahora, cuando puedes generar bloques enteros de código funcional en minutos, esa resistencia se vuelve menor.

Cambiar estructuras grandes, probar enfoques nuevos o descartar algo que no sirve ya no es un drama; es parte del flujo.

Sin embargo, aquí viene el giro: aunque la IA nos da velocidad y calidad, no nos quita el volante. Las habilidades de diseño de sistemas se vuelven más críticas que nunca.

Somos nosotros quienes orquestamos cómo funcionan los agentes, quienes definimos las instrucciones y decidimos cómo todo se conecta. Sí, el código aparece casi como por arte de magia, pero sigue siendo nuestra responsabilidad revisarlo, ajustarlo y asegurarnos de que encaje en el gran esquema.

Todavía no estamos en el punto de soltar a un agente libre en nuestro codebase, haciendo cambios o creando features sin supervisión y dudo que queramos estarlo pronto.

¿Hacia dónde vamos en 2025?

Nuestro rol está evolucionando: Nos estamos convirtiendo en algo más parecido a PMs técnicos, dirigiendo un equipo invisible de agentes que ejecutan nuestras ideas. La IA nos libera de lo repetitivo, pero nos empuja a pensar más en arquitectura, estrategia y visión.

Adaptarnos a este nuevo juego no es opcional: es la clave para sacarle el máximo jugo a esta era. Porque al final, aunque el código vuele, el diseño y quienes lo dirigen sigue siendo lo que hace que todo funcione.

Glosario:

Si apenas estás entrando al mundo de la IA, aquí va una guía rápida y clara para entender los términos que están por todos lados:

LLM (Large Language Model): Modelos de lenguaje grandes, como ChatGPT o Claude. Son IAs entrenadas con toneladas de texto para generar respuestas o código. Podemos verlos como cerebros que hablan con un lenguage que podamos entender.

RAG (Retrieval-Augmented Generation): Es como darle a un LLM una biblioteca. Antes de responder, busca info relevante en documentos o bases de datos para no inventarse cosas.

MCP (Model Context Protocol): Un estándar nuevo de Anthropic. Deja que agentes usen herramientas remotas (no locales) con un sistema claro: el agente pide, un servidor responde, un host tiene la herramienta. Ejemplo: Cursor leyendo tickets de Linear sin integrarlo directamente.

NLP (Natural Language Processing): Procesamiento del lenguaje natural. Es la magia detrás de cómo las IAs entienden y generan texto humano. Todo esto depende de NLP.

RPC (Remote Procedure Call): Un concepto viejo de programación donde una app llama funciones que están en otro servidor. Tool calling se inspira en esto, pero para agentes.

Tool Calling: Cuando un agente usa funciones de código como si fueran herramientas. Ejemplo: pedirle que calcule algo y lo hace llamando una función.

Prompt Chaining: Usar la respuesta de un LLM como entrada para otro. Es como pasarle la batuta entre modelos para tareas complejas.

Agentes: IAs que no solo responden, sino que actúan: deciden, llaman herramientas, coordinan. Son el siguiente nivel después de los LLMs básicos.

Flujos (Workflows): Secuencias de tareas que un agente sigue. Piensa en una receta: paso 1, paso 2, resultado.